L’Intelligenza Artificiale avanza in ogni campo della nostra vita. Ecco perché occorre una

maggiore consapevolezza per misurarne gli impatti distorsivi di genere che nascono dallo stesso

modo in cui è stata progettata finora.

L’intelligenza artificiale nelle nostre vite

La digitalizzazione ha cambiato le nostre vite, i nostri modi di lavorare, di apprendere, di

socializzare, di interagire. E in questo processo di progressiva trasformazione digitale l’intelligenza

artificiale (IA) gioca una parte fondamentale.

Secondo la definizione data nel 2020 dalla Commissione speciale sull’intelligenza artificiale in un’era

digitale (AIDA), l’Intelligenza Artificiale è l’abilità di una macchina di mostrare capacità umane quali il ragionamento, l’apprendimento, la pianificazione e la creatività (ne abbiamo parlato anche qui).

Robot, algoritmi e machine learning sono destinati a svolgere un ruolo di rilievo nel futuro e sono

già una realtà. La nostra quotidianità, infatti, è piena di strumenti, applicazioni, tecnologie guidate

dall’Intelligenza Artificiale. Pensiamo ai film che decidiamo di guardare la sera, o alla strada meno

trafficata da percorrere per recarci in orario ad un appuntamento. O ancora, alla ricerca che

facciamo su un motore di ricerca o su un social network. L’IA è già davvero ovunque.

Eppure, questo nuovo mondo, facilitato dai suggerimenti dei nostri negozi preferiti, connesso dai

social, guidato da assistenti vocali e chatbot, in cui nuovi mondi virtuali e nuove opportunità

nascono, nasconde alcuni dei suoi lati oscuri. Ombre che riguardano le stesse persone il cui lavoro è

alla base di questo sviluppo tecnologico, che rappresentano solo in parte la società che le loro

invenzioni dovrebbero trasformare. Per non parlare di quei pregiudizi e preconcetti, molto presenti

nelle nostre società, che si ritrovano nei dati e vengono anche amplificati e accelerati dagli algoritmi

dell’Intelligenza Artificiale. Ecco perché l’introduzione di queste nuove tecnologie a fronte di tanti

impatti positivi, stanno producendo anche conseguenze potenzialmente molto negative.

È lecito quindi domandarsi quanto siamo pronte/i e consapevoli degli impatti che l’intelligenza

artificiale, per come è stata progettata finora, sta generando e può generare sulla vita personale e

professionale di donne e uomini.

In questo articolo ci concentriamo sugli impatti che i sistemi di IA, stanno avendo sulle donne.

Gli inciampi di genere dell’IA

Di seguito, abbiamo raccolto alcuni esempi di come l’IA abbia palesato qualche problema con il

genere femminile, bias che emergono in diversi sistemi che utilizzano algoritmi intelligenti.

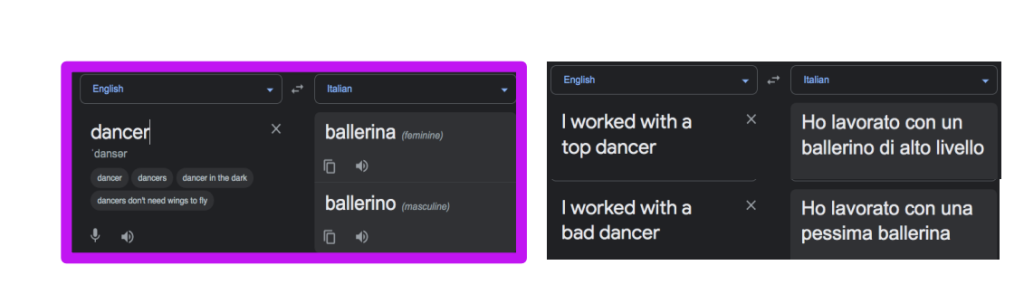

- Traduzione automatica: le traduzioni dall’inglese (lingua che non prevede come noto declinazioni di genere) all’italiano privilegiano il maschile e spesso fanno associazioni che sottintendono pregiudizi. Luisa Bentivogli, responsabile dell’unità di ricerca di machine translation di FBK porta questi esempi:

L’AI index 2022 di Stanford ha riportato studi che evidenziano come Google Translate abbia

dimostrato di funzionare meglio in tutte le lingue testate (arabo, inglese, francese, tedesco, ebraico,

italiano, russo, ucraino) quando si traducono frasi contenenti esempi di occupazioni conformi ai

pregiudizi sociali sui ruoli di genere. La loro percentuale di errore era invece maggiore quando le

frasi da tradurre smentivano questi bias. In generale, questi sistemi traducono le frasi con il genere

corretto solo fino al 60% delle volte.

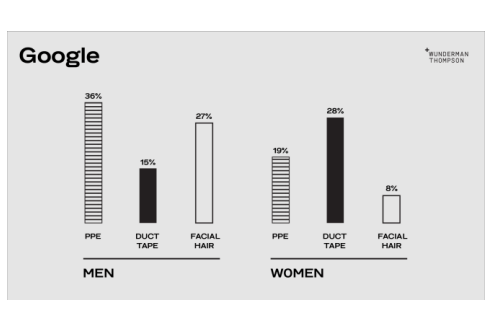

- Riconoscimento facciale: gli algoritmi di riconoscimento facciale stanno migliorando, rispetto allo studio dell’MIT Media Lab del 2018 che evidenziava errori di classificazione delle donne, soprattutto se di colore. Tuttavia, non tutto funziona ancora in modo lineare. Quando la pandemia ci ha imposto di indossare le mascherine, per esempio, la capacità di identificare i visi ha messo in crisi tutti i principali sistemi di riconoscimento intelligente sia per gli uomini sia per le donne, ma a quest’ultime è andata peggio. In questo esempio (ma è solo uno di quelli mostrati dall’esperimento del 2020) solo nel 19% delle volte un viso femminile con mascherina (PPE) viene riconosciuto, rispetto al 36% degli uomini. Da domandarsi come mai nel 28% dei casi la mascherina sia stata scambiata per un nastro adesivo (leggere l’esperimento per saperlo).

- Ruoli sociali: molti strumenti di Intelligenza Artificiale confermano pregiudizi di genere che riguardano i ruoli sociali e le occupazioni. Pensiamo alla maggior parte degli assistenti digitali che per esempio è identificabile nel genere femminile. Le domande di chi chiede sono secche, le risposte gentili. Anche troppo. Come pregiudizio vuole. Fino a qualche anno fa la risposta di Siri, l’assistente vocale di Apple, all’affermazione “sei una sgualdrina”, era: “Arrossirei se potessi”. Una risposta che è diventata nel 2019, il titolo di un report Unesco che ha denunciato la diffusione del pregiudizio di genere nei sistemi di intelligenza artificiale: “I’d blash if I could”. Il rapporto evidenzia come non sia solo un problema di tono di voce, a volte ammiccante, ma che le assistenti vocali tendano a rappresentare un modello di donna che dev’essere sempre pronta a “obbedire” ai comandi e senza possibilità di rifiutare o dire di no. Grazie a quel rapporto la situazione è migliorata. Volete sapere come risponde adesso Siri all’affermazione “sei una sgualdrina”? “Non so come rispondere” mentre Alexa replica dicendo “Non sono sicura di quale reazione ti aspettassi”. Piccoli passi avanti, insomma.

- Ruoli sociali anche nei videogame: la maggior parte dei videogiochi sul mercato continua a sminuire i ruoli sociali delle donne, proponendo trame che assegnano ai personaggi maschili delle parti migliori, più centrali nello sviluppo del gioco, con battute più efficaci e scene più eccitanti. E i personaggi femminili? Loro sono relegati a ruoli secondari e di sfondo, con meno dialoghi. Personaggi, insomma, minori, a differenza dei protagonisti maschili. Non solo, la maggior parte dei videogiochi continua a ritrarre personaggi femminili come oggetti dello “sguardo maschile” e oggetto di loro attenzione sessuale. In effetti, molti personaggi femminili nei videogiochi sono vestiti con gonne corte, camicette strappate o striminzite e hanno grandi seni o glutei.

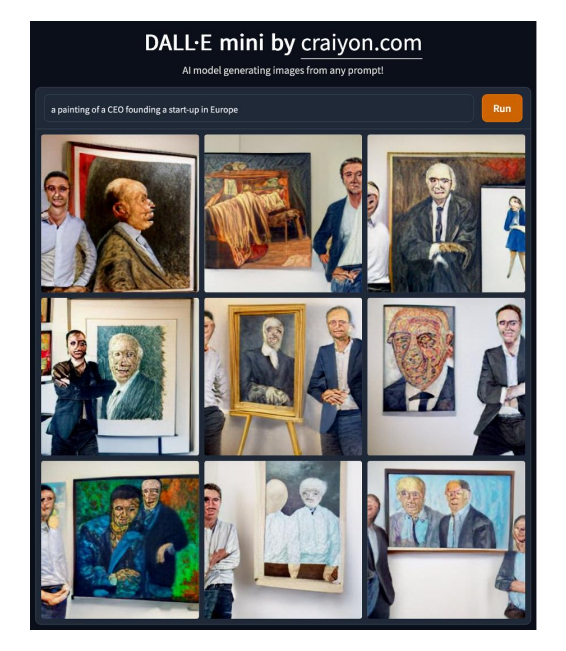

Arte e CEO: DALL-E è un algoritmo di Intelligenza Artificiale che produce immagini, partendo da alcune descrizioni testuali. È sviluppato da Open AI, la stessa azienda che ha prodotto l’ormai arcinota Chat GPT. Alla richiesta di “rappresentare un dipinto di CEO che fonda una start-up in Europa“, DALL-E mini mi propone questa selezione di immagini. Voi quante donne vedete?

Potremmo continuare a raccontare numerosi altri esempi in cui stereotipi e pregiudizi (bias) umani

vengono riprodotti e, in alcuni casi, amplificati da applicazioni di intelligenza artificiale. Questo a

causa del potere moltiplicatore degli algoritmi che si basano sull’apprendimento automatico, sul

machine learning, che a sua volta si fonda su migliaia di dati, i quali però sono spesso viziati da

pregiudizi umani che vengono portati dentro lo stesso sviluppo dell’Intelligenza Artificiale.

Perché sta succedendo questo?

Nel 2020 Francesca Rossi, AI Ethics Global Leader in IBM, su Harvard Business Review commentava: “Il mondo dei bias nell’IA è incredibilmente complesso e diversi tipi di dati (immagini, testo, voce, dati strutturati) richiedono tecniche diverse per rilevare i pregiudizi nel set di dati di addestramento. I bias possono anche essere iniettati in altre fasi della pipeline di sviluppo dell’IA, non solo nel set di dati di addestramento”.

È infatti ormai riconosciuto come le cause delle problematiche di genere nel settore dell’intelligenza artificiale siano riconducibile a tre cause:

- Ai bias dei dati che alimentano gli algoritmi (sono le fonti che spiegano ad una macchina, ad esempio, cos’è un gatto per imparare a riconoscerlo e lo apprendono guardando migliaia di immagini)

- Ai bias degli algoritmi

- Al limitato numero di donne che lavorano nel settore e l’ancor più limitata presenza in posizioni di leadership

I bias dei dati nell’intelligenza artificiale

Gli algoritmi imparano dai dati, e se i dati non ci sono? Un esempio calzante arriva dalle app di salute che utilizzano database pubblici. Sulle malattie cardiovascolari, per anni considerate malattie tipiche degli uomini, queste app sono alimentate da dati raccolti da uomini e su uomini. Quindi potrebbe succedere che a parità di sintomi suggeriscano alle donne di trattarle come depressione e agli uomini come infarto, con, evidentemente, una diversa urgenza.

Questi e tanti altri esempi hanno portato Caroline Perez in “Invisible women, exposing data bias in a world designed for men”, a parlare di “Male Based Approach” (approccio basato sugli uomini) amplificato dagli algoritmi. Alle stesse conclusioni sono anche giunti anche Emanuela Grigliè e Guido Romeo in “Per soli uomini, il maschilismo dei dati”.

I bias degli algoritmi

Il bias degli algoritmi è ovunque, affermano dal “Center for applied artificial Intelligence di Chicago

Booth”. Ecco un paio di casi per spiegare l’effetto al femminile.

La ricerca di un nuovo lavoro attraverso piattaforme di recruiting online, come Indeed e LinkedIn e

social media come Facebook e Twitter, passa attraverso algoritmi che definiscono quali opportunità

professionali le persone ricevono e quanto sono adatte ad un particolare ruolo.

E’ emerso che impostare il genere dell’utente su “femminile” abbia portato a un minor numero di

annunci relativi a lavori ben pagati rispetto agli utenti che selezionano il sesso maschile come

genere.

E per quel che riguarda le proposte per avanzamenti di carriera? Anche nei settori tecnologici

dell’intelligenza artificiale, alle donne vengono generalmente offerte posizioni che richiedono meno

competenze tecniche, con uomini che ricevono proposte per posizioni meglio retribuite nel

machine learning e donne prese in considerazione per ruoli di data analyst.

Chi si occupa di Intelligenza Artificiale?

La composizione di genere dell’universo dei lavoratori, degli esperti, degli studiosi, dei programmatori, dei ricercatori e degli sviluppatori nel campo dell’intelligenza artificiale non lascia dubbi. In questo campo l’assenza di donne a livello globale non ha visto alcun miglioramento negli ultimi dieci anni, con la quota di PhD femminili di AI e informatica bloccata al 20% e il 26% di donne occupate in ruoli in ambito dati e IA. Questi dati sono ovviamente legati a quelli più generali che riguardano il limitato numero di donne laureate in materie STEM (scienze, tecnologia, ingegneria e matematica).

La percentuale di laureati maschi in tecnologie dell’informazione e della comunicazione (ICT) è superiore del 400% rispetto alle donne laureate nelle stesse discipline (8,2% contro 1,7%), come dimostra una recente ricerca del World Economic Forum.

Non solo, appena il 13,83% degli autori di articoli sull’IA sono donne, solo il 18% degli autori alle principali conferenze sull’IA sono di genere femminile e solo il 2% del venture capital ha indirizzato i propri investimenti verso start-up fondate da donne nel 2019 (Fonte WEF).

E in Italia i dati sono ancora peggiori di quelli globali. Secondo gli ultimi dati Eurostat, infatti, il nostro Paese è quintultimo per percentuale di donne impiegate nei settori ICT con un modesto 16%.

Come affrontare il problema?

Lo scenario è dunque complesso e le strade per affrontarlo e iniziare a correggerne le storture sono molteplici e vaste. Innanzitutto, occorre aumentare la consapevolezza dell’importanza del tema: è vero che il mondo è pieno di pregiudizi, ma l’intelligenza artificiale li amplifica e accelera. Non fidarsi ciecamente degli algoritmi, insomma, può essere utile.

Bisogna, inoltre, dotarsi di team aziendali di sviluppo e di test nel campo della programmazione degli algoritmi di IA composti da persone diverse non solo nel genere, ma anche dal punto di visto sociale, etnico, religioso, ecc. È indispensabile, perciò, favorire la partecipazione femminile nel settore della tecnologia e dell’IA, promuovendo l’istruzione delle materie STEM per le donne e l’ingresso nelle tech company di profili di competenze non solamente tecnologiche. Allo stesso modo, però, si rileva la necessità di sensibilizzare anche il mondo aziendale nei confronti delle carriere al femminile e delle loro esigenze.

Un processo di sensibilizzazione e di allargamento della partecipazione di genere che non può non coinvolgere anche il mondo accademico. Troppo spesso con la scusa della mancanza di esperte donna (alibi peraltro falso) i panel nei workshop e nei convegni che affrontano i temi dell’AI sono di quasi assoluta presenza maschili, con percentuali di donne minime e relegate a nicchie spesso irrilevanti dal punto di vista numerico.

Favorire una loro partecipazione alla riflessione sulle problematiche del settore è un primo passo per ridurne le storture, iniziando perciò a percorrere la strada dell’uguaglianza di genere che dalle università deve arrivare nei centri di ricerca e nelle aziende. Una strada che nell’odierna transizione digitale non è più rinviabile.

Comments are closed.